Inhaltsverzeichnis

ToggleKünstliche Intelligenz prägt das Web-Crawling

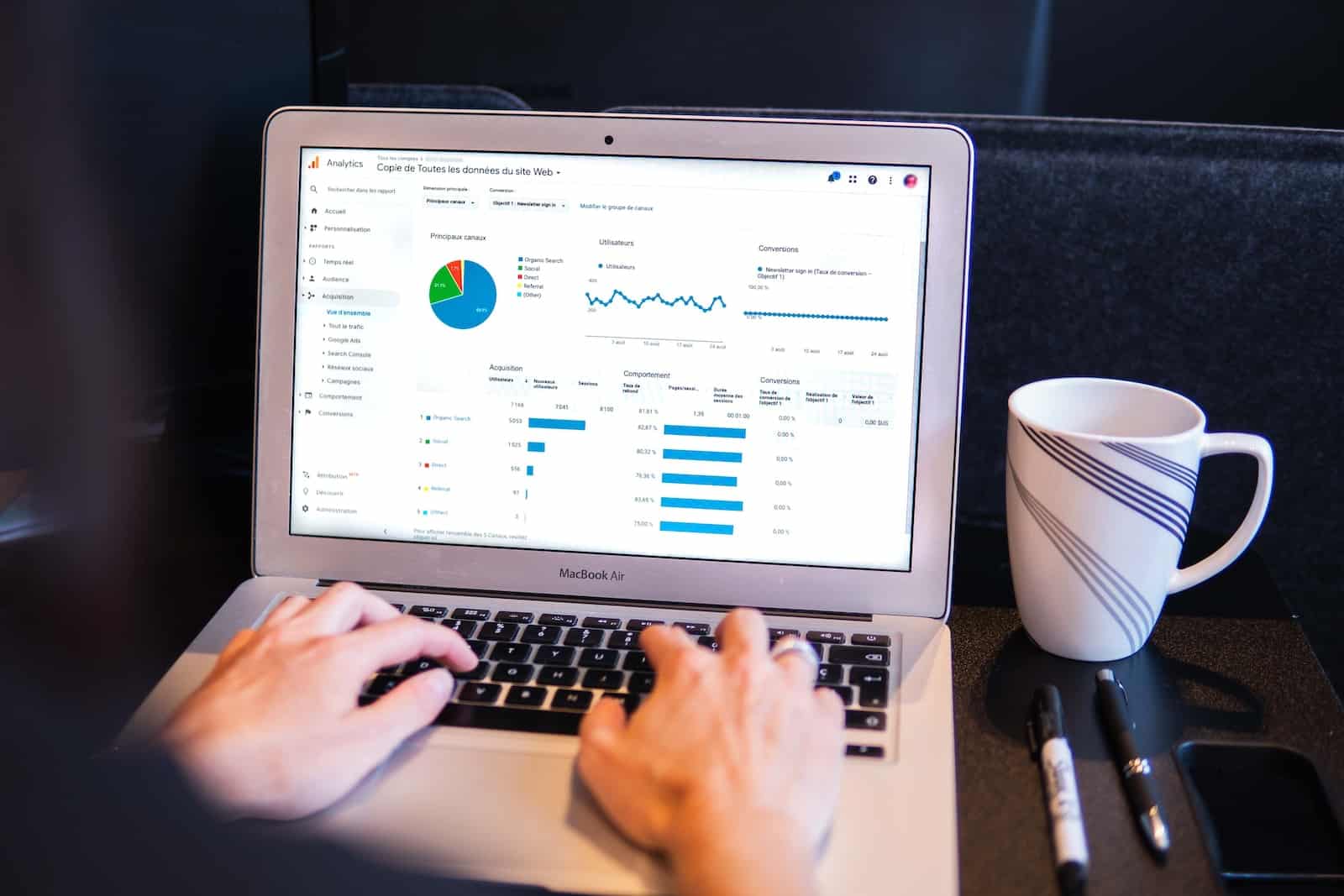

Künstliche Intelligenz (KI) revolutioniert die Webwelt. Laut einer Studie von Vercel machen KI-Webcrawler bereits 28 % des Datenverkehrs von Googlebot aus. Dazu gehören leistungsstarke Bots wie GPTBot von OpenAI und Claude von Anthropic. Diese Bots führen monatlich Millionen von Anfragen aus und breiten sich immer mehr aus – eine Entwicklung, die die Zukunft der SEO-Landschaft entscheidend verändert.

Einflussreiche Zahlen

GPTBot allein tätigte innerhalb eines Monats 569 Millionen Anforderungen, und Claude steuerte 370 Millionen bei. Auch andere Bots wie PerplexityBot und AppleBot tragen erheblich zum Webverkehr bei. Interessanterweise stehen diese Zahlen im direkten Vergleich mit Googlebots rund 4,5 Milliarden Anforderungen. Es wird deutlich, welche entscheidende Rolle KI im digitalen Ökosystem spielt.

Verhaltensmuster von KI-Crawlern

Technische Erkenntnisse

Die Studie zeigte, dass KI-Webcrawler bestimmte technische Ansätze bevorzugen:

- Die meisten analysieren keine JavaScript-Inhalte, sondern extrahieren lediglich die zugehörigen Dateien.

- Erstaunlich ineffizient: Über 34 % der Anforderungen führen zu 404-Fehlerseiten.

- Die Art der gesuchten Inhalte variiert stark. Während GPTBot mehr HTML-Daten einholt, liegt der Fokus von Claude auf Bildern.

Geografischer Fokus

Interessanterweise operieren KI-Bots derzeit hauptsächlich aus den USA. GPTBot ist in Des Moines und Phoenix aktiv, während Claude in Columbus ansässig ist. Das zentrale Zusammenspiel auf US-Standorte beschränkt die globale Reichweite derzeit noch.

Optimierung für KI-Crawler

Die neue Ära von KI hat dazu geführt, dass Webmaster die Optimierung ihrer Inhalte anpassen müssen. Hier sind drei wirkungsvolle Ansätze:

1. Serverseitiges Rendering

Da KI-Crawler JavaScript nicht ausführen, sollten essenzielle Inhalte und Metadaten serverseitig bereitgestellt werden. Dies stellt sicher, dass kritische Daten von solchen Bots erkannt werden.

- Verwende serverseitiges Rendering, um alle wichtigen Inhalte im HTML bereitzustellen.

- Erwäge die Nutzung statischer Seitengeneration, um den Bot-Zugriff weiter zu verbessern.

2. Inhalte klar strukturieren

Die Untersuchung von Vercel zeigte deutliche Präferenzen für verschiedene Inhalte. GPTBot priorisiert beispielsweise HTML, während Claude automatisch mehr auf Bilder abzielt. Basierend darauf solltest du:

- HTML-Strukturen klar und semantisch gestalten.

- Bilder optimieren, einschließlich Metadaten und alternativer Textbeschreibungen.

- Eine korrekte Header-Hierarchie einhalten.

3. Technische SEO im Fokus

Korrekte Weiterleitungen, gut gepflegte Sitemaps und die Vermeidung von 404-Fehlerseiten sind entscheidend, um KI-Webcrawler effizient zu bedienen. Nutze diese Best Practices:

- Stelle funktionierende und aktuelle Sitemaps zur Verfügung.

- Optimiere URL-Strukturen und beseitige „tote Links“.

- Führe regelmäßig technische Audits durch, um Fehler zu minimieren.

Blick in die Zukunft

SEO-Strategen müssen sich bewusst sein, dass KI-Webcrawler zunehmend Einfluss auf das Crawlen von Webseiten nehmen. Obwohl KI-Bots aktuell oft auf ältere, gecachte Daten angewiesen sind, wird ihre Fähigkeit, auf aktuelle Inhalte zuzugreifen, schnell wachsen. Somit ist es wichtig, SEO-Pläne dynamisch für beide Ansätze – klassische Suchmaschinen und KI-Systeme – zu gestalten.

Fazit

Künstliche Intelligenz nimmt Fahrt auf und verändert, wie und was auf Websites analysiert wird. Investiere in innovatives SEO, indem du Inhalte präsent und zugänglich machst – sowohl auf technischer Seite als auch beim User Interface. Dies ist mehr als ein neuer Trend; es ist die unausweichliche Richtung der digitalen Zukunft.